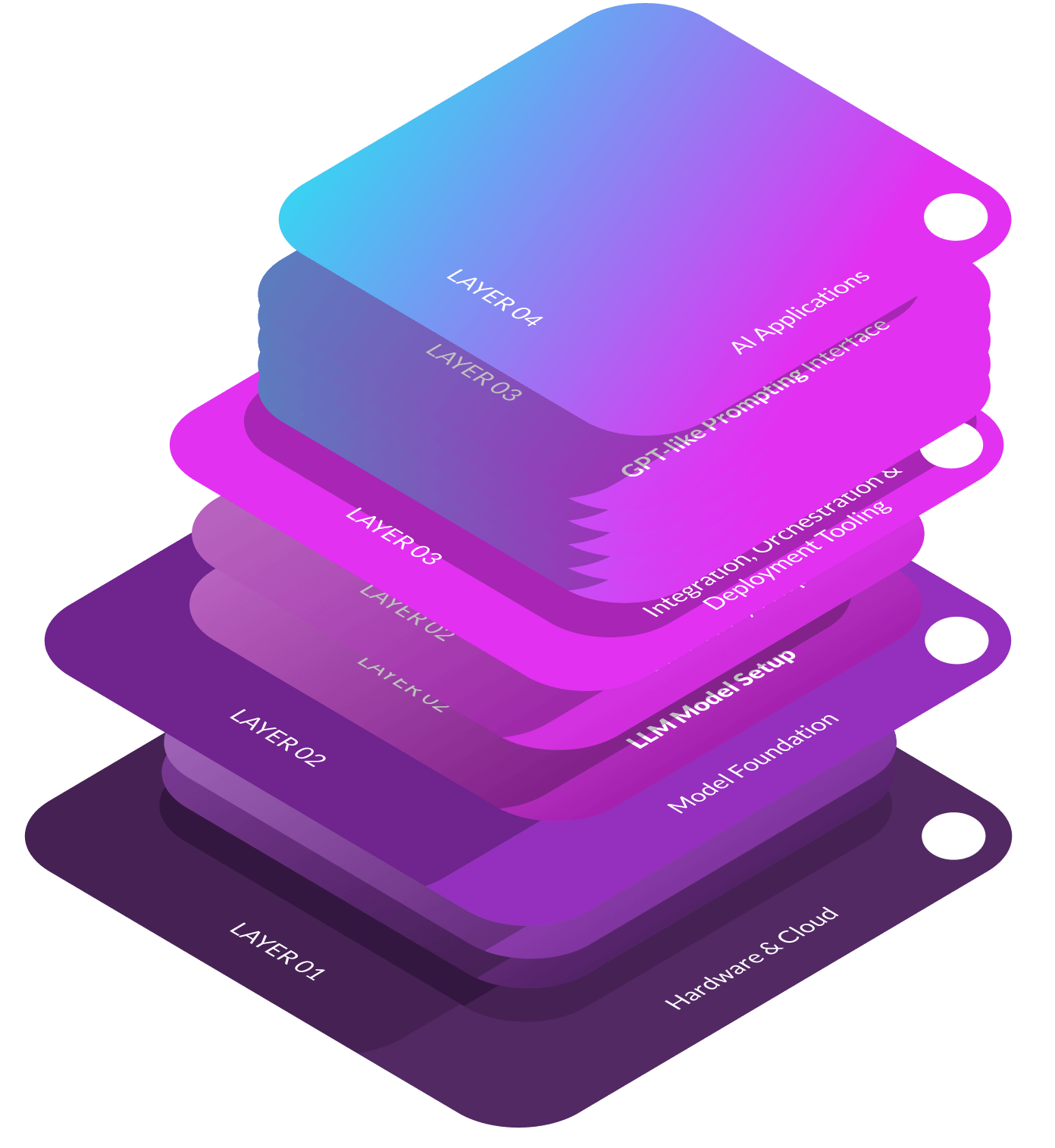

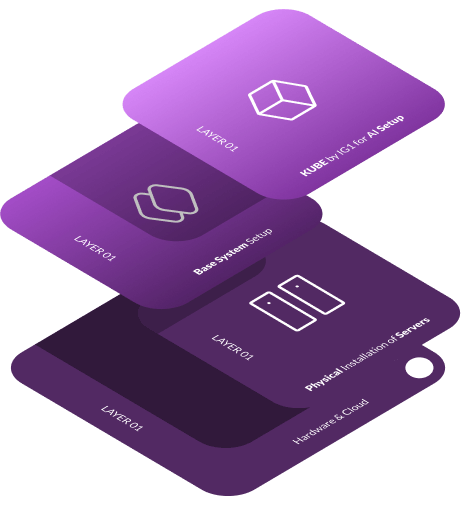

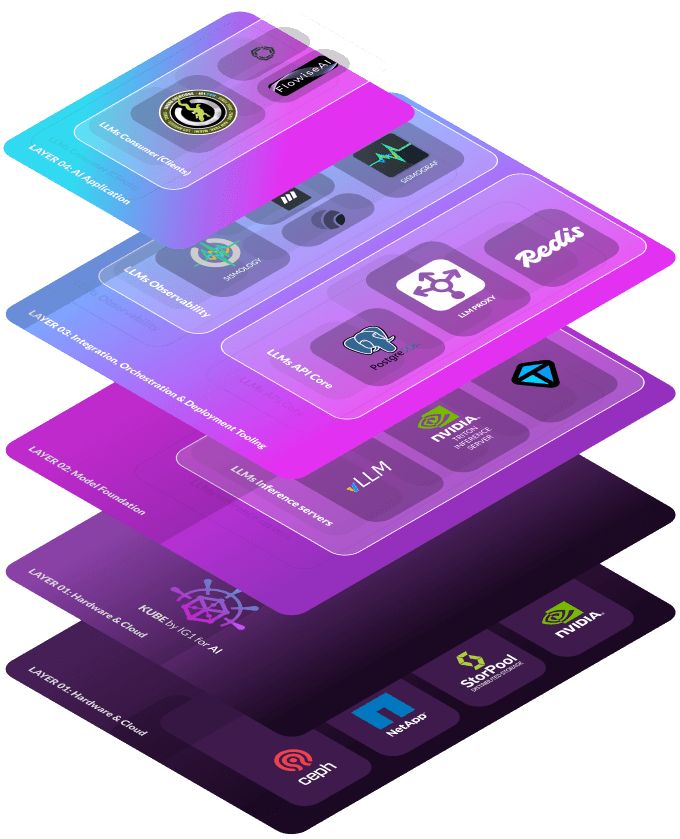

Capa 02: Fundación del modelo LLM y despliegue RAG

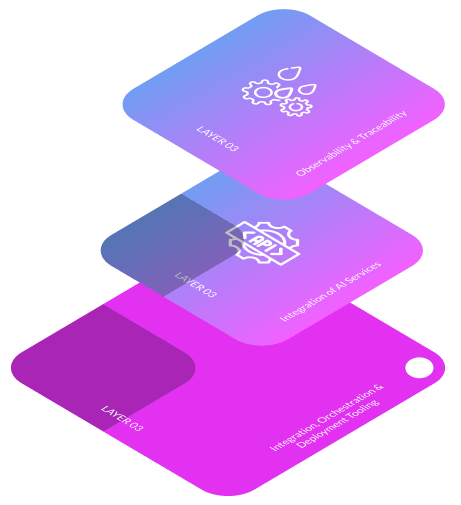

Las aplicaciones de IA se basan en modelos generativos, como LLAMA3, Mistral, Deepseek y StarCoder, que son modelos preentrenados en vastos conjuntos de datos para captar patrones y conocimientos complejos. Estos modelos sirven como bloques de construcción para diversas tareas de IA, como el procesamiento del lenguaje natural y la generación de imágenes. Para desplegar y gestionar eficazmente las aplicaciones de IA, se necesitan varios servicios que garanticen el correcto funcionamiento de los grandes modelos lingüísticos (LLM). Estos servicios incluyen cuantificación para la optimización de recursos, servidores de inferencia para la ejecución de modelos, núcleo API para el equilibrio de cargay observabilidad para la recopilación de datos y la gestión de trazas. Al ajustar y optimizar estos modelos en conjuntos de datos específicos, se puede mejorar su rendimiento y precisión para tareas especializadas. Este paso fundamental permite a los desarrolladores aprovechar modelos sofisticados, reduciendo el tiempo y los recursos necesarios para crear aplicaciones de IA desde cero.

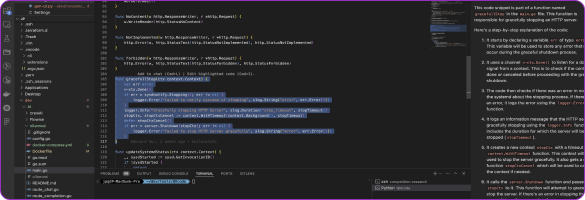

Configuración del modelo LLM

Descargue el LLM (Large Language Model) y realice la cuantización para optimizar el rendimiento y reducir el uso de recursos. Este paso garantiza que el modelo de IA se ejecute de forma eficiente y esté listo para su integración con otros componentes.

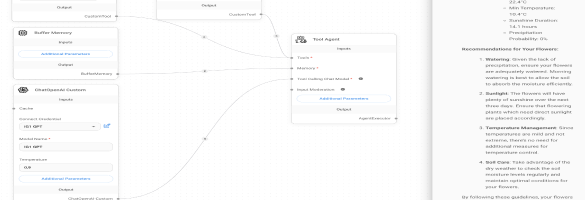

Configuración RAG (Recuperación-Generación mejorada )

Integre los componentes RAG utilizando el marco más utilizado y despliegue la canalización RAG dentro de KUBE. Este paso mejora el modelo de IA con capacidades mejoradas de recuperación, proporcionando respuestas más precisas y relevantes.